This article is available in three languages, so make sure to choose your preferred language on the right.

2024 ist ein Jahr mit mehreren fünfjährigen Jubiläen für mich. Dabei rede ich nicht vom 70. Geburtstags meines Lieblingsautos und meiner Lieblingsgitarre. Nein, dieses Jahr ist es

- 30 Jahre seit meinem ersten Job

- 25 Jahre seit ich mit dem Studium Geodäsie und Geoinformatik an der Uni Stuttgart angefangen habe.

- 20 Jahre seit ich das Studium als Diplom-Ingenieur beendet habe und als Doktorand an der TU Delft angefangen habe

- 15 Jahre seit ich erfolgreich meine Dissertation verteidigt habe und die akademische Welt verlassen habe um in der echten Welt mein Glück zu versuchen

- 10 Jahre seit ich die Sicherheit einer großen Firma verlassen habe um Teil eines kleinen Start-Ups zu werden, was mich letztendlich dorthin geführt hat wo ich jetzt beruflich bin

Also jede Menge Jubiläen, wobei 25 Jahre Geodäsie dasjenige ist, das meine Zukunft am Meisten bestimmt hat. Eine gute Gelegenheit um sowohl 25 Jahre zurück als auch vorauszuschauen.

Geodäsie und Vermessung vor 25 Jahren

Der Jahrtausendwechsel war eine interessante Zeit für die Geodäsie. Mehrere technische Entwicklungen erreichten Reife und haben damit die Vermessungswelt transformiert.

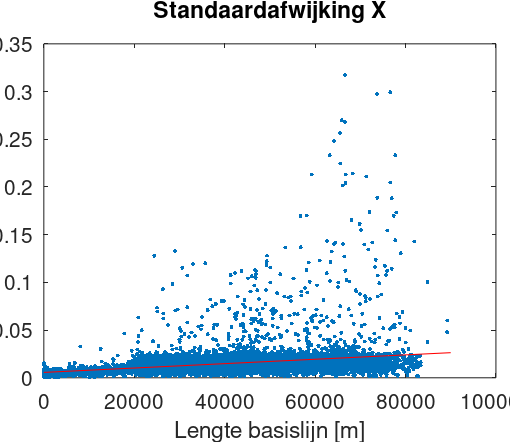

GPS wird erwachsen

Die Geschichte von GPS geht zurück in die 70er Jahre. Im ersten Golfkrieg 1992 konnten amerikanische Streitkräfte eine unvollständige Konstellation verwenden, auch auch der Einsatz zu Vermessungszwecken begann in dieser Zeit, war aber in den 1990ern noch weit vom Mainstream entfernt. Als ich 2000 beim Vermessungsamt Calw mein Praktikum machte, hatte die Vermessungsbehörde von Baden-Württemberg ein einziges RTK-GPS Team. Da es noch keine kommerziellen Korrekturdienste gab, brauchte man immer zwei Empfänger mit Funkverbindung. Im Fall des Leica System 500, das wir auch an der Uni hatten, bestand ein Empfänger aus einer Antenne, einer Bedieneinheit mit Display und Knöpfen und dem Empfänger selber, den man typischerweise in einem Rucksack trug da er recht groß und schwer war.

Ein Schlüsselmoment für die zivile Nutzung von GPS war das Abschalten von Selective Availability im Jahr 2000, wodurch die Genauigkeit auf einmal bei rund 1m war, womit auch Autonavigation mittels GPS möglich war. Für Vermessungszwecke kam der Durchbruch mit kleineren und günstigen integrierten Empfängern und der Verfügbarkeit von landesweiten Korrekturnetzen, mit denen der Empfänger sich über GSM Modem verbinden konnte, wodurch die Notwendigkeit für einen zweiten Empfänger für RTK entfiel.

GPS und seine Konkurrenten haben massiven Einfluss auf die Geodäsie gehabt, nicht immer im positiven Sinn. Es hat uns die Möglichkeit gegeben, genaue Messungen über große Entfernungen auszuführen die vorher undenkbar waren. Aber die Verfügbarkeit einer genauen Koordinate auf Knopfdruck hat auch zu einer gewissen „Verdummung“ des Vermessungswesen geführt, da geodätisches Grundwissen weniger wichtig ist als früher.

Der Aufstieg des Robottachymeters

Die Einführung des Tachymeters, einer Kombinaten von Theodolit und elektronischem Entfernungsmesser, in den 70er Jahren hat das Vermessungswesen revolutioniert. Auf einmal war es möglich, mit einer einzigen Messung 3D Koordinaten zu erhalten. Der nächste Evolutionsschritt waren motorisierte Robottachymeter die autonom Prismen finden und messen konnten. Dadurch wurde automatisches Monitoring und selbst das Folgen bewegender Prismen möglich, wobei die Leica TCA1800 und TCA2003 Tachymeter, die wir an der Uni hatten, eigentlich so langsam waren, dass man so damit eigentlich nicht arbeiten konnte. Das änderte sich mit den Leica TPS1200 und Trimble S6, die (vor allem das Trimble) deutlich schneller waren und eingebaute Funkgeräte für die Fernbedienung hatten. Hatte ein Vermessungsteams während meines Praktikums noch zwei oder manchmal sogar drei Personen, so war ein paar Jahre später der Solovermesser die Norm, ausgerüstet mit Robottachymeter und GPS-Empfänger.

Eine weitere Entwicklung in dieser Zeit war die Markteinführung von Tachymetern die reflektorlos (also ohne Prisma) messen konnten, ein weiteres Feature das heutzutage normal ist. Die heutigen Tachymeter entsprechen weitgehend denen von vor 20 Jahren.

Die digitale Fotografie tritt auf die Bildfläche

Mein erster Kontakt mit der digitalen Fotografie war 1999, da einer meiner Zugkameraden eine sehr teure Canon Digitalkamera gekauft hatte, die wahrscheinlich 1,3 Megapixel Auflösung hatte. Während meines Studiums waren Filmkameras noch der Standard für Luftbildaufnahmen und Photogrammetrie, da es anfänglich schwierig war um Kameras mit der benötigten Auflösung für Luftbilder zu machen. Die zwei Kontrahenten zu dieser Zeit waren die Z/I Imaging DMC und die Leica ADS40. Erstere hatte mehrere rechteckige Sensoren, die zweite Zeilensensoren. Das DMC Konzept hat sich letztendlich durchgesetzt und wird prinzipiell auch heute noch eingesetzt, Z/I Imaging gibt es aber nicht mehr.

Digitale Photogrammetrie hatte einen enormen Einfluss. In der Filmära musste man teuren Film kaufen, entwickeln und dann für digitale Weiterverarbeitung scannen. Mit Digitalkameras verschwanden die Zwischenschritte und wurde Fotografie praktisch kostenlos, bis auf die Kosten um die Kamera in die Luft zu bekommen und die Daten zu verarbeiten. Photogrammetrie ist heutzutage eine der Grundtechniken der Vermessung, egal ob von Flugzeugen, Drohnen, Autos oder sogar aus der Hand für Detailaufnahmen z.B. von gebautem Erbgut.

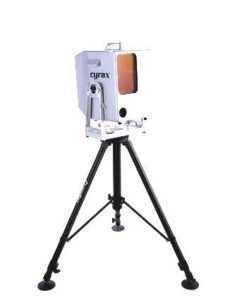

Hier komt der Laserscanner.

Wie bei GPS und Tachymetern liegen die Wurzeln des Laserscanners in den 70er Jahren, aber der Marktdurchbruch hat deutlich länger gedauert. An der Uni haben wir die erste Demo 2003 bekommen. Leica hatte gerade Cyra Technologies übernommen. Ihr Laserscanner war, verglichen mit den heutigen Scanners, viel langsamer mit einem sehr schmalen Sichtfeld. Die Datenverarbeitung mit Cyclone (den Namen verwendet Leica noch immer für seine Scansoftware) war langsam und benötigte viel Handarbeit, und ich wurde ausgelacht als ich meinte, dass man da mehr automatisieren müsste. Da hat sich in den letzten 20 Jahren doch einiges getan… Laserscanner sind noch immer teuer, trotzdem ist Laserscanning inzwischen fast so allgegenwärtig wie die anderen Messtechniken, dank der Fortschritte in Hard- und Software.

Ein Blick voraus

Zurückschauen macht um willen der Nostalgie Spaß, aber was hat die Zukunft für uns Geodäten im Petto? Hier sind ein paar Sachen die mir eingefallen sind.

Die 3Dfizierung von Allem

Ich habe oben geschrieben, dass ein Tachymeter 3D Koordinaten liefern konnte, aber zumindest beim Kadaster wurde davon selten bis nie Gebrauch gemacht. Lage und Höhe waren unterschiedliche Sachen. In den Niederlanden z.B. ist das Lagesystem Aufgabengebiet des Kadasters und das Höhensystem von Rijkwaterstaat, der Wasser- und Verkehrsbehörde. Selbst GPS, eine intrinsische 3D Messmethode, wird oft nur für Lagekoordinaten verwendet.

Zum Glück werden in den letzten Jahren die Vorteile von 3D deutlich. Das kommt sicherlich auch teilweise durch Fortschritte auf Softwaregebiet. Spieleengines und Techniken wie WebGL haben es einfacher gemacht, um 3D Daten zu visualisieren und zu benützen. In der Kombination mit Laserscannung und Photogrammetrie als Messmethoden bin ich mir sicher, dass 3D in den kommenden Jahren immer mehr verwendet und wichtiger werden wird.

Mobile Mapping ist überall

Vor 25 Jahren waren Luftbildaufnahmen eigentlich die einzige Mobile Mapping Technik, da es weder Sensoren noch Navigationssysteme gab, die für den Einsatz auf Straßenfahrzeugen geeignet waren. Dank bezahlbarer GNSS/INS Navigationssysteme, Laserscanning, digitaler Fotografie und Techniken wie SfM (Structure from Motion) und SLAM (Simultaneous Localization and Mapping) kann Mobile Mapping inzwischen in fast jedem Maßstab eingesetzt werden, von einer Person die mit einem Smartphone ein Object „scant“, über personengebundene Mappingsysteme die auch in Gebäuden verwendet werden können, Drohnen, Fahrzeuge bis zu Flugzeugen. Die Herausforderung liegt nicht mehr in der Datengewinnung, sondern a) in der Qualitätssicherung und b) in der Extraktion nützlicher Informationen. Nichtsdestotrotz erwarte ich, dass traditionele Einzelpunktmessmethoden in der Zukunft an Bedeutung verlieren werden, außer in Bereichen mit hohen Genauigkeitsanforderungen.

Cloud vs. Edge Computing

Cloud Computing, vor 15 Jahren noch ein Modewort, ist inzwischen Alltag, wobei in der Aussage „Die Cloud ist auch nur der Computer von jemand anders“ sicherlich ein Kern von Wahrheit steckt. Die Cloud bietet vor allem Vorteile gegenüber traditionellen on-premise Lösungen wenn es um die Skalierbarkeit geht. Aber Cloud Computing ist nicht die Antwort auf alles, mit den Hauptproblemen meiner Meinung nach a) der Herausforderung, die großen Datenmengen, die mit modernen Mobile Mapping Systemen generiert werden, in die Cloud zu bekommen, und b) Kosten, da Cloudlösungen für den Dauereinsatz oft deutlich teurer sind als on-premise Lösungen.

Auf der anderen Seite sehen wir Edge Computing, was prinzipiell bedeutet, dass die Daten auf einem Computer verarbeitet werden, der direkt am Sensor hängt, wodurch die Datenmenge die transferiert und weiterverarbeitet werden muss, deutlich reduziert wird. Ansätze hiervon sind im Mobile Mapping zu sehen. z.B. mit dem Anonymisieren von Bildern schon während der Fahrt, und meiner Meinung nach ist dies eine wichtige Entwicklung, um den immer weiter wachsenden Datenmengen Herr zu werden.

KI

Wenn du nicht gerade unter einem Stein lebst, dann wird dir aufgefallen sein, dass künstlicher Intelligenz zur Zeit das heiße Thema ist. Die Medien konzentrieren sich dabei vor allem auf generative KI, als künstliche neuronale Netzwerke die neue Dinge wie Text, Bilder und selbst Videos generieren können. Aber KI/Deep Learning und Machine Learning im Allgemeinen haben eine wichtige Rolle in der Datenverarbeitung, egal ob um die Klassifizierung von Punktwolken, Objekterkennung oder NeRFs (neural radiance fields) die eine kompakte Beschreibung von 3D Szenen bieten geht. Die Erklärbarkeit und training bias bleiben Herausforderungen, wie auch die Rechenleistung die für KI benötigt wird. Welche Auswirkung KI haben wird, ist zum jetzigen Zeitpunkt noch schwierig einzuschätzen.

Alles ist miteinander verbunden

Das gilt nicht nur für die vier obigen Themen, wobei ein KI Algorithmus mittels Cloud oder Edge Computing Mobile Mapping Daten verarbeitet um ein 3D Produkt zu generieren, sondern für alles. Unsere Hardware, unser Software, letztendlich unser Leben ist heutzutage über Netzwerke verbunden und würde ohne nicht funktionieren. Obwohl es fast unmöglich ist, alle Entwicklungen zu folgen, folgt der maximale Nutzen nur aus der richtigen Kombination aller technischen Möglichkeiten. Darum brauchen wir sowohl Spezialisten, die die immer komplexeren Systeme begreifen, als auch die Generalisten die den Überblick behalten. Ich arbeite gerne in der Gegenwart, aber ich bin auch froh, die Geodäsie vor 25 Jahren mitgemacht zu haben.